Über meine Eindrücke von Lightroom 6 habe ich euch ja schon ausführlich berichtet. Ein offener Punkt war noch die Performance Frage und ob sich die Investition in eine schnellere Grafikkarte lohnt. Immerhin hat Adobe ja vollmundig versprochen, durch die Auslagerung von Berechnungslogik in beschleunigte Grafikkarten, fantastische Performance Vorteile zu erzielen. Ich habe nun eine sehr schnelle Grafikkarte getestet und möchte euch, wie versprochen, berichten.

Am Ende gibt es dann noch ein kurzes Video, wo ich Lightroom mal einen kleinen Wettlauf machen lasse…

Vor dem Umbau hatte ich in meinem Rechner eine Geforce 660 Ti – eine Karte von Anfang 2013, die nach 2 Jahren sicherlich auch noch nicht zum ganz alten Eisen gehört. Allerdings hat sich in den letzten 2 Jahren aber doch etwas getan, und so soll die Geforce GTX 980, die ich mir nun bestellt habe, mehr als doppelt so schnell sein, zumindest laut Gegenüberstellungen im Netz. Die GTX 980 ist schon relativ «High End», vom Preis/Leistungsverhältnis her, wäre die GTX 970 wohl besser gewesen.

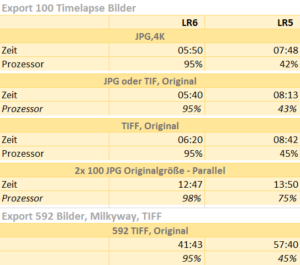

Ich habe sie also eingebaut und zunächst einmal den Test wiederholt, den ich neulich schon gemacht habe: Bilder exportiert. Einer der absoluten Flaschenhälse in Lightroom, das hatte ich euch ja schon im Video gezeigt. Und was ich schon vermutet hatte, hat sich bestätigt: an den Zeiten hat sich nichts geändert.

Kein Wunder, denn mittlerweile hat Adobe auch Details dazu preisgegeben, für welche Funktionen Lightroom 6 überhaupt nur die Grafikkartenunterstützung einsetzt:

Hierfür nutzt Lightroom 6 / CC Grafikkartenbeschleunigung:

- nämlich nur für die Echtzeitdarstellung der meisten (Ausnahmen s.u.) Entwicklungseinstellungen im Entwickeln-Modul

Und ja, das geht auch bei mir jetzt gefühlt flotter mit der neuen Grafikkarte. Aber ehrlich gesagt ist das schwer zu vergleichen, deswegen eben «gefühlt». Ansich war die Performance in dem Bereich bei mir auch schon vorher okay. Ein Bewegen der Regler löst mit der GTX980 Änderungen am Bild so gut wie in Echtzeit aus. Allerdings nur, wenn Lightroom nicht im Hintergrund Bilder exportiert, HDR’s zusammensetzt oder ein Panorama berechnet! Dann nämlich, wird alles relativ zäh, da die Prozessoren voll ausgelastet sind.

Folgendes profitiert derzeit in Lightroom 6 / CC nicht von einer schnellen Grafikkarte:

- Die Bibliothek und alle anderen Module – außer Entwickeln

- Die Schnellentwicklung in der Bibliothek

- Der Export (!)

- Die HDR Funktion

- Die Panorama Funktion (hätte mich auch gewundert!)

- Der Korrektur-Pinsel und die Bereichsreparatur im Entwickeln-Modul (probiert es mal aus, der ist nun schnarchlahm, wenn die Grafikkartenbeschleunigung eingeschaltet ist)

- Der zweite Bildschirm, falls ihr Lightroom im Zweischirm-Betrieb fahrt

So, da haben wir es. Die Grafikkarte beschleunigt also nur die direkte Auswirkung der Regler auf das Bild im Entwickeln Modul.

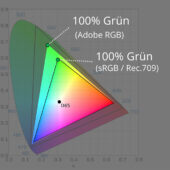

Hochauflösende Monitore

Und Adobe hat mittlerweile auch erklärt, warum sie das Thema überhaupt angehen mussten: immer mehr Kunden setzen mittlerweile hochauflösende Monitore ein. Während ein normaler Full-HD-Bildschirm 2 Megapixel darstellt, sind es bei einem 4K-Display schon 8MP und bei 5K ganze 15 MP. Die Anzahl der darzustellenden Pixel wächst also quadratisch und ich gehe davon aus, dass die alte Ansteuerung hier massiv an ihre Grenzen gestoßen ist.

Adobe stellt klar, dass die Grafikkarten-Beschleunigung umso mehr Effekt hat, je größer die Auflösung des Bildschirms ist! Mit einem Full HD-Bildschirm werdet ihr also kaum einen Unterschied merken, mit einem 4K Bildschirm hingegen schon.

Mangels eines Solchen, kann ich euch dazu leider derzeit keine Praxis-Erfahrungen liefern, aber es klingt plausibel.

Adobe erklärt aber auch, dass auch die Grafikkarte keine Wunderwaffe sei und eben nur bestimmte Aufgaben, nämlich solche, die sich gut parallelisieren lassen, hier sinnvoll ausgelagert werden können. Weiterhin gibt es einen gewissen «Overhead» dadurch, dass die Daten ja zunächst vom Hauptspeicher in die Grafikkarte geladen werden müssen, bevor sie dort verarbeitet werden können. Das merkt man dann, wenn unterstützte Werkzeuge mit nicht Unterstützten (Pinsel, Bereichsreparatur) interagieren.

Als kleine Hoffnung spricht Adobe davon, dass die derzeitige Umsetzung in Lightroom 6 nur der Anfang sei. Es steht also zu hoffen, dass mit wachsender Erfahrung in dieser Art der Beschleunigung auch weitere Funktionen entsprechend beschleunigt werden.

Meine Einschätzung

«Grafikkartenbeschleunigung» ist schon fast zu einem Marketing-Begriff geworden. Dass selbst bei einer angepriesenen solchen Unterstützung keine Wunder zu erwarten sind, zeigt das aktuelle Lightroom 6. Dass es auch anders geht, zeigt z.B. die beliebte Software zur Panoramaberechnung PTGui. Die dort vor einiger Zeit eingeführte Unterstützung von Grafikprozessoren hat zu einer enormen Beschleunigung beim Zusammensetzen von Panoramen geführt. Davon kann Adobe derzeit nur träumen. Aber der Knackpunkt ist: schon ohne die Grafikkarten-Unterstützung war PTGui bereits deutlich schneller als die Adobes Panorama Funktion. Und hier liegt meines Erachtens nach ein Teil des Problems, das Lightroom schon lange mit sich herum trägt.

Anstatt sich nun darauf zu stürzen, werbewirksam die Funktionalitäten eines Moduls nach dem anderen in die Grafikkarte auszulagern, könnte Adobe sich auch mal den Kern-Programmcode vornehmen. Schlechte Programmierung ist nämlich die größte und häufigste Ursache für Performance Engpässe.

Dazu habe ich ein kurzes Video für euch gemacht, in dem ich Lightroom mal zum «Wettrennen» herausgefordert habe. Aber seht selbst…

Das Wettrennen – Video

Ich muss es noch einmal wiederholen: auch, wenn das jetzt drastisch aussieht: es schmälert nichts daran, dass Lightroom ein großartiges Tool ist! Wir jammern hier auf hohem Niveau. Und meiner Meinung nach ist LR6/CC nicht langsamer, als die Vorversion. Den gerade erschienene Einschätzung von Heise Photo zum Thema Lightroom Performance kann ich, bei allem Respekt für den Heise Verlag, nicht ganz nachvollziehen.

Meine Empfehlung

Solltet ihr euch nun eine neue Grafikkarte kaufen?

Das hängt davon ab. Folgende Fragen solltet ihr euch stellen:

- Lohnt es sich noch, euren Rechner aufzurüsten und ist es überhaupt möglich? Aus meiner Sicht macht es bei Rechnern, die älter als 4 Jahre sind, keinen Sinn eine moderne Grafikkarte einzusetzen. Hier wärt ihr mit mehr Hauptspeicher und schnellen SSDs sicherlich besser bedient.

- Habt ihr einen Monitor mit höherer Auflösung, als Full HD oder plant ihr, einen solchen zu kaufen? In diesem Fall kann eine neue Grafikkarte etwas bringen und wird auch bei Lightroom den größten Effekt ausspielen.

- Merkt ihr, wenn eure Rechner sonst im Leerlauf ist, beim Betätigen der Regler im Entwickeln-Modul große Latenzen? Dann könnte eine schnellere, beschleunigte Grafikkarte helfen.

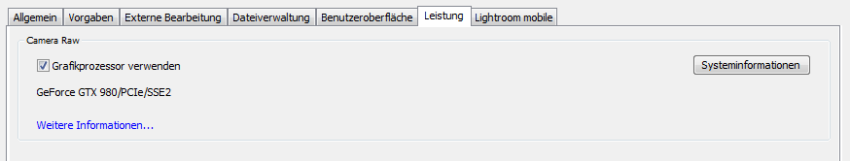

Ob die Grafikkartenbeschleunigung bei eurem Rechner von Lightroom derzeit überhaupt genutzt wird, seht ihr übrigens in Lightroom unter «Voreinstellungen -> Leistung».

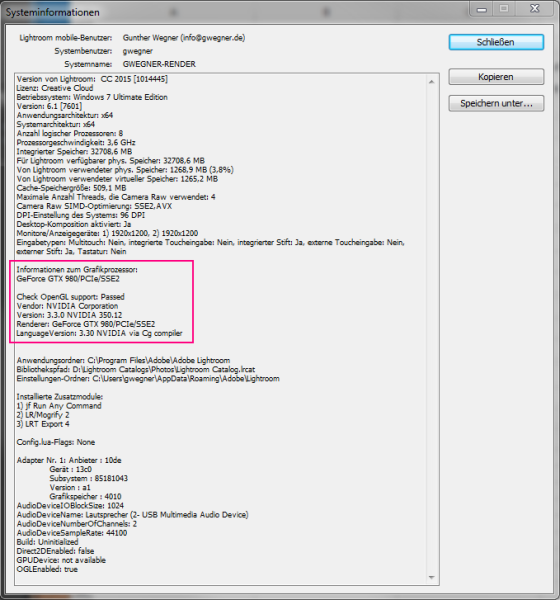

Wenn ihr nicht wisst, welche Grafikkarte ihr habt, findet ihr Infos darüber unter «Systeminformationen»:

Vergesst nicht, dass die Grafikkarte nur eine Komponente in einem Rechner ist. Bevor ihr hier investiert, solltet ihr auf jeden Fall vorher in Hauptspeicher und schnelle SSDs investiert haben, die bringen nämlich einen deutlich größeren Effekt bezüglich der Performance!

Mit dem von mir vor 2 Jahren zusammengestellten Rechner kann ich, da ich die Komponenten damals sorgfältig ausgewählt habe, heute immer noch ohne Performance-Einbußen arbeiten und das auch bei anspruchsvoller Nutzung. Selbst, wenn ich gleichzeitig Sequenzen mit LRTimelapse rendere und ein Video mit Premiere Pro ausgebe, kann ich noch flüssig arbeiten.

Die neue Grafikkarte hat sich derzeit vom Preis-/Leistungsverhältnis für mich sicherlich nicht unbedingt gelohnt – aber vielleicht steht dann ja doch irgendwann mal ein 4K Monitor an… :-)

Hat Dir der Artikel gefallen?

Dann melde Dich doch bitte zu meinem kostenlosen Newsletter an. Dann bekommst Du eine Nachricht bei neuen Artikeln und Du wirst auch exklusiv als erstes über neue Workshops und Reisen informiert! Außerdem gibt es dort auch immer wieder Hintergrund-Infos, die so nicht im Blog stehen.

Natürlich freue ich mich auch sehr, wenn Du mir bei YouTube, Instagram und Facebook folgst.

Alle Inhalte © Gunther Wegner

*) Mit einem Stern gekennzeichnete Links sind externe Partner-Links. Ihr unterstützt mich, wenn ihr darüber bestellt. Alternativ könnt ihr auch über folgende Direktlinks in die Shops wechseln:

Amazon.de, Amazon.at, Amazon.com, Foto Koch, Augenblicke-Eingefangen, camforpro.com.

Über meine Zusammenarbeit mit externen Partnern habe ich hier ausführlich geschrieben. Danke!